A Apple anunciou um conjunto de ferramentas de segurança infantil destinadas a proteger os jovens usuários e limitar a disseminação de material que retrata o abuso sexual infantil.

Entre as ferramentas está uma nova tecnologia que permitirá à Apple detectar imagens conhecidas de abuso sexual infantil armazenadas nas contas iCloud Photo dos usuários e denunciá-las às autoridades policiais. O processo de detecção não envolverá a inspeção manual indiscriminada do conteúdo iCloud dos usuários.

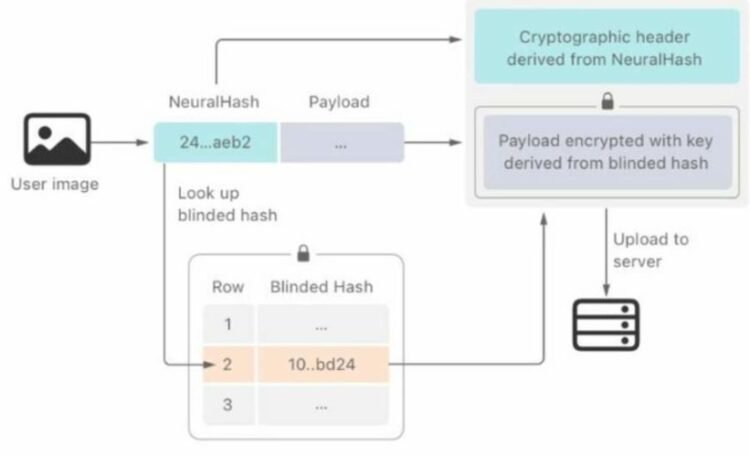

Em vez disso, utilizará uma nova ferramenta chamada “NeuralHash” que é baseada em um banco de dados de hashes – uma impressão digital que permite identificar um conteúdo único mas não reconstruído – que representa imagens conhecidas de um banco de dados fornecido por organizações de segurança infantil; os hashes serão armazenados localmente. Outras grandes empresas de tecnologia – incluindo Facebook, Microsoft e Google – já utilizam o mesmo banco de dados para detectar conteúdo de abuso sexual infantil em suas próprias plataformas.

A ferramenta permite que imagens editadas similares aos originais sejam detectadas, embora por projeto não possa detectar novos conteúdos de abuso infantil.

A verificação ocorre quando um usuário tenta carregar uma imagem em seus servidores; quando um limite de correspondências é excedido, o conteúdo suspeito pode ser revisado manualmente antes que uma denúncia seja enviada às autoridades policiais e a conta do usuário seja suspensa. Os usuários que acreditam que sua conta foi inapropriadamente suspensa podem apelar para que ela seja reintegrada.

A Apple enfatizou que a nova ferramenta só se aplicaria ao iCloud Photos e que não permitiria que ela ou qualquer terceiro escaneie as imagens em um rolo de câmera do usuário. A empresa disse que o sistema é projetado para reduzir os falsos positivos a um em um trilhão.

O sistema procura encontrar um compromisso entre segurança infantil e privacidade do usuário, sendo este último um pilar da marca. John Clark, CEO do National Centre for Missing and Exploited Children nos EUA, saudou o novo recurso como uma mudança no jogo: “Com tantas pessoas usando produtos Apple, estas novas medidas de segurança têm potencial para salvar vidas de crianças que estão sendo seduzidas on-line e cujas imagens horríveis estão sendo circuladas em material sobre abuso sexual infantil. A realidade é que a privacidade e a proteção da criança podem coexistir”.

Embora a recepção do anúncio da Apple tenha sido amplamente positiva, alguns defensores da privacidade expressaram a preocupação de que a ferramenta poderia eventualmente ser expandida para buscar em telefones de forma mais geral conteúdos proibidos, como discursos politicamente sensíveis.

Matthew Green comentou a pesquisa de segurança da Universidade John Hopkins: “[A Apple] tem enviado um sinal muito claro. Em sua opinião (muito influente), é seguro construir sistemas que procurem conteúdo proibido nos telefones dos usuários. Isto vai quebrar a represa – os governos vão exigi-lo de todos”.

Fonte: Apple